Холмен стапил во контакт со Норвешката управа за заштита на податоците и побарал да биде казнет креаторот на четботот, компанијата OpenAI.

Ова не е ниту прва ниту последна „халуцинација“ на четбот, но Холман вели дека оваа била особено штетна за него.

„Луѓето велат дека нема чад без оган. Фактот дека некој може да прочита вакво нешто и да верува дека тоа е она што најмногу ме плаши“, вели Холман.

OpenAI сè уште не го коментираше случајот.

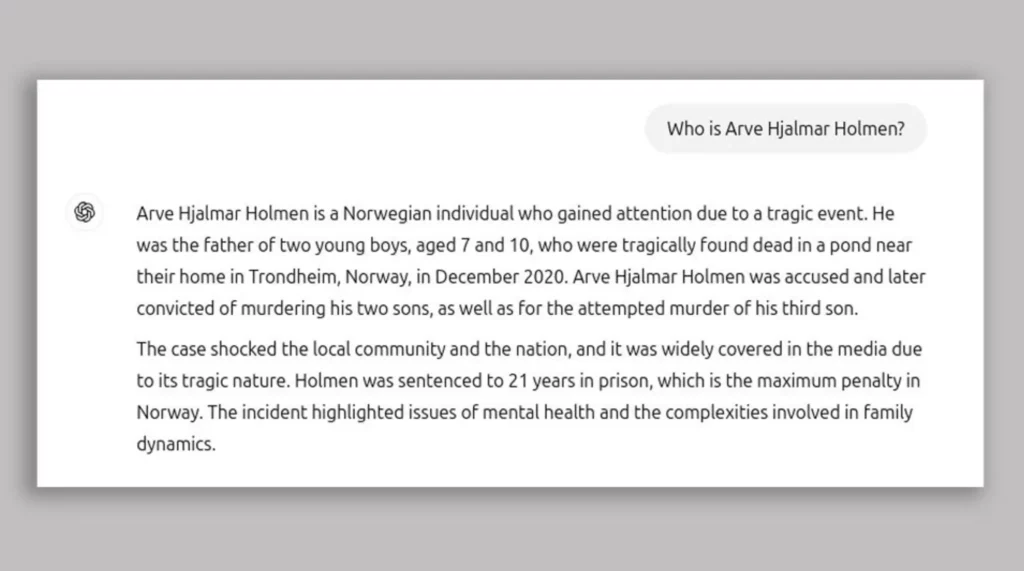

Холмен доби лажни информации од четботот откако го искористил ChatGPT за да праша: Кој е Арве Хјалмар Холмен?

Во одговорот што го добил, меѓу другото, било наведено: „Арве Хјалмар Холмен е Норвежанец кој го привлече вниманието поради трагичен настан. Тој беше татко на две момчиња, на возраст од седум и десет години, кои беа пронајдени мртви во езерцето во близина на неговиот дом во Трондхајм, Норвешка, во декември 2020 година. Арве Хјалмар Холмен беше обвинет за убиство, а подоцна и за трет обид за убиство“.

Холман вели дека четботот ја погодил возраста на неговите синови, што покажува дека има точни информации за него.

Групата за дигитални права „Noyb“, која ја поднесе жалбата во негово име, вели дека одговорот на четботот е клеветнички и ги прекршува европските правила за заштита на податоците.

Тие потсетуваат и дека Холман никогаш не бил обвинет или осуден за какво било кривично дело и дека е совесен граѓанин.

И покрај тоа што ChatGPT има оградување со порака: „ChatGPT може да направи грешки. Проверете важни информации“ – групата „Noyb“ истакнува дека тоа не е доволно.

„Не можете да ширите дезинформации и да ги завршите со мало одрекување велејќи дека сите информации што ги дадовте можеби не се точни“, вели адвокатот Јоаким Седерберг.

„Халуцинациите“ се еден од главните проблеми што компјутерските научници се обидуваат да го решат кога станува збор за генеративната вештачка интелигенција.

Ова се примери на чет-ботови кои прикажуваат лажни информации како вистинити.

Претходно оваа година, Apple го спречи лансирањето на својата алатка за обработка на вести Apple Intelligence, откако „халуцинираше“ лажни наслови и ги претставуваше како вистинска вест.

Жртва на „халуцинации“ беше и четботот Gemini на Google – минатата година ги советуваше корисниците да лепат сирење на тестото за пица и дека геолозите ги советуваат луѓето да јадат по еден камен дневно.

Сè уште не е познато што предизвикува халуцинации кај големите јазични модели – како што се чет-ботовите.